私たちの脳は、骨ばった頭蓋骨に包まれた 3 ポンドの組織の塊であり、どのようにして感覚から知覚を生み出すのかは長年の謎です。豊富な証拠と何十年にもわたる継続的な研究は、脳がジグソー パズルを組み立てるかのように感覚情報を単純に組み立てて周囲を知覚することはできないことを示唆しています。これは、入ってくる情報がうるさくて曖昧であっても、目に入る光に基づいて脳がシーンを構築できるという事実によって裏付けられています。

その結果、多くの神経科学者は、脳を「予測機械」と見なす方向に傾いています。予測処理を通じて、脳は世界に関する事前の知識を使用して、着信する感覚情報の原因について推論を行ったり、仮説を立てたりします。これらの仮説は、感覚入力自体ではなく、私たちの心の目に知覚を生じさせます。入力が曖昧であるほど、以前の知識への依存度が高くなります。

Predictive Brain の神経科学者である Floris de Lange は、次のように述べています。オランダのラドバウド大学の研究室

しかし、この考えに対する神経科学的証拠の増加は主に状況に基づくものであり、別の説明が可能です。 「人間の認知神経科学と神経画像を調べると、多くの証拠がありますが、非常に暗黙的で間接的な証拠です」と、機械学習と神経科学の学際的な分野を研究しているラドバウド大学のティム・キーツマンは述べています。 .

そのため、研究者は予測脳のアイデアを理解し、テストするために計算モデルに目を向けています。計算神経科学者は、入ってくる情報について予測を行うことを学習する、生物学的ニューロンの動作に着想を得た設計の人工ニューラル ネットワークを構築しました。これらのモデルは、実際の脳の能力を模倣しているように見えるいくつかの驚くべき能力を示しています。これらのモデルを使ったいくつかの実験は、エネルギーの制約を満たすために、脳が予測機械として進化しなければならなかったことを示唆しています.

また、計算モデルが急増するにつれて、生きた動物を研究している神経科学者も、脳が感覚入力の原因を推測することを学習することを確信するようになっています。脳がこれをどのように行っているかについての正確な詳細はあいまいなままですが、大まかな筆跡はより明確になりつつあります.

知覚における無意識の推論

予測処理は、最初は直感に反して複雑な知覚メカニズムのように見えるかもしれませんが、他の説明が必要であると思われたため、科学者がそれに目を向けてきた長い歴史があります。 1000 年前でさえ、イスラム教徒のアラブ人の天文学者で数学者のハサン イブン アル ハイサムは、彼の Book of Optics でその形式を強調しました。 視覚のさまざまな側面を説明します。この考えは 1860 年代に勢いを増し、ドイツの物理学者で医師のヘルマン フォン ヘルムホルツが、脳は入力された感覚入力から「ボトムアップ」で知覚を構築するのではなく、その入力の外的原因を推測すると主張しました。

ヘルムホルツは、この「無意識の推論」の概念を説明して、画像を複数の方法で知覚できる双安定または多安定知覚を説明しました。これは、たとえば、アヒルまたはウサギとして認識できるよく知られたあいまいなイメージで発生します。私たちの認識は、2 つの動物のイメージの間を行き来します。そのような場合、ヘルムホルツは、網膜上に形成される画像は変化しないため、知覚は感覚データの原因に関するトップダウンの推論の無意識のプロセスの結果であるに違いないと主張しました.

20 世紀の間、認知心理学者は、知覚はボトムアップの感覚入力とトップダウンの概念入力の両方を利用した能動的な構築のプロセスであるという事例を構築し続けました。この取り組みは、影響力のある 1980 年のリチャード ラングトン グレゴリーによる影響力のある論文「Perceptions as Hypotheses」で最高潮に達し、知覚的錯覚は本質的に、感覚的印象の原因に関する脳の誤った推測であると主張しました。一方、コンピューター ビジョンの科学者は、参照用の内部「生成」モデルなしでコンピューターが認識できるようにするために、ボトムアップの再構成を使用することに失敗しました。

ユニバーシティ カレッジ ロンドンの計算神経科学者である Karl Friston は、次のように述べています。

しかし、予測処理が受け入れられるようになった一方で、それが脳にどのように実装されるかについては疑問が残りました。予測コーディングと呼ばれる一般的なモデルの 1 つは、脳内の情報処理レベルの階層を主張しています。最高レベルは、最も抽象的で高レベルの知識を表します (たとえば、前方の影にいるヘビの認識など)。この層は、信号を下方に送信することにより、下の層の神経活動を予測して予測を行います。下位層は、実際の活動を上からの予測と比較します。不一致がある場合、層は上向きに流れるエラー信号を生成し、上位層がその内部表現を更新できるようにします。

このプロセスは、実際の感覚入力を受け取る最下層まで、連続する層の各ペアで同時に発生します。世界から受け取ったものと予想されているものとの間に矛盾があると、エラー信号が発生し、階層に波及します。最上位層は最終的にその仮説を更新します (それは結局のところヘビではなく、地面に巻かれたロープであるということです)。

「一般的に、予測コーディングの考え方は、特に大脳皮質に適用される場合、脳には基本的に 2 つのニューロン集団があるということです」と de Lange 氏は述べています。その予測の誤り。

1999 年、コンピュータ科学者の Rajesh Rao と Dana Ballard (当時はそれぞれソーク生物学研究所とロチェスター大学に所属していた) は、予測とエラー修正のために明示的にニューロンを備えた予測コーディングの恐るべき計算モデルを構築しました。彼らは、霊長類の脳の視覚処理システムの経路の一部をモデル化しました。視覚処理システムは、顔や物体の認識に関与する階層的に組織化された領域で構成されています。彼らは、モデルが霊長類の視覚系のいくつかの異常な行動を再現できることを示しました.

ただし、この作業は、最新のディープ ニューラル ネットワークが登場する前に行われました。ディープ ニューラル ネットワークには、1 つの入力層、1 つの出力層、および 2 つの間に挟まれた複数の隠れ層があります。 2012 年までに、神経科学者はディープ ニューラル ネットワークを使用して霊長類の腹側視覚ストリームをモデル化していました。しかし、これらのモデルのほとんどはフィードフォワード ネットワークであり、情報は入力から出力にのみ流れます。 「脳は明らかに純粋なフィードフォワード マシンではありません」と de Lange 氏は述べています。 「脳には、フィードフォワード [シグナリング] とほぼ同じくらい多くのフィードバックがあります。」

そこで神経科学者は、再帰型ニューラル ネットワーク (RNN) と呼ばれる別のタイプのモデルに目を向けました。計算神経科学者であり、ニューヨークのマウント サイナイにあるアイカーン医科大学の准教授でもある Kanaka Rajan 氏によると、これらは脳をモデル化するための「理想的な基質」となる機能を備えており、その研究室では RNN を使用して脳機能を理解しています。 RNN には、ニューロン間にフィードフォワード接続とフィードバック接続の両方があり、入力に依存しない一定の進行中のアクティビティがあります。 「これらのダイナミクスを非常に長い期間、本質的に永遠に生成する能力は、これらのネットワークにトレーニングを行う能力を与えるものです」と Rajan 氏は述べています。

エネルギー効率の良い予測

RNN は、ハーバード大学の William Lotter と彼の博士論文アドバイザーである David Cox と Gabriel Kreiman の注目を集めました。 2016 年、チームはビデオ シーケンスの次のフレームを予測することを学習した RNN を披露しました。彼らはそれを PredNet と呼んでいました (「より良いものを考え出すのに十分な創造性がないことは私に責任があります」と Lotter 氏は言います)。チームは、予測コーディングの原則に沿って RNN を 4 つのレイヤーの階層として設計しました。各レイヤーは、下のレイヤーから予想される入力を予測し、不一致がある場合はエラー信号を上に送信します。

次に、車に取り付けられたカメラから撮影された街の通りのビデオでネットワークをトレーニングしました。 PredNet は、ビデオの次のフレームを継続的に予測することを学習しました。 「それが実際に機能するかどうかはわかりませんでした」と Lotter 氏は言います。 「試してみたところ、実際に予測を行っていることがわかりました。そしてそれはとてもクールでした。」

次のステップは、PredNet を神経科学に接続することでした。昨年の Nature Machine Intelligence 、Lotter と同僚は、PredNet が予期しない刺激に反応してサルの脳に見られる行動を示すことを報告しました。これには、単純なフィードフォワード ネットワークでは複製するのが難しいものも含まれます。

「それは素晴らしい仕事です」と、Kietzmann 氏は PredNet について語っています。しかし、彼、Marcel van Gerven と Radboud の同僚たちは、もっと基本的なことを求めていました。Rao と Ballard のモデルと PredNet の両方に、予測とエラー修正のための人工ニューロンが明示的に組み込まれています。 .しかし、それらが明示的に指定されていない場合はどうなるでしょうか? 「この「ベイクイン」アーキテクチャの制約のすべてが本当に必要なのか、それとももっと単純なアプローチでうまくいくのか疑問に思いました」とキーツマン氏は述べています。

キーツマンとヴァン・ゲルヴェンが思いついたのは、神経伝達はエネルギー的にコストがかかるということでした (脳は体内で最もエネルギー集約的な器官です)。したがって、エネルギーを保存する必要性は、生物の進化するニューラル ネットワークの動作を制約する可能性があります。

研究者は、予測コーディングのための計算メカニズムのいずれかが、可能な限り少ないエネルギーでタスクを実行しなければならない RNN で出現する可能性があるかどうかを確認することにしました。彼らは、ネットワーク内の人工ニューロン間の接続の強さ (重みとも呼ばれる) が、シナプス伝達の代用として機能する可能性があると考えました。シナプス伝達は、生物学的ニューロンのエネルギー使用量の多くを占めています。 「人工単位間の重みを減らすと、より少ないエネルギーで通信できることを意味します」とキーツマンは言いました。 「私たちはこれをシナプス伝達を最小限に抑えていると考えています。」

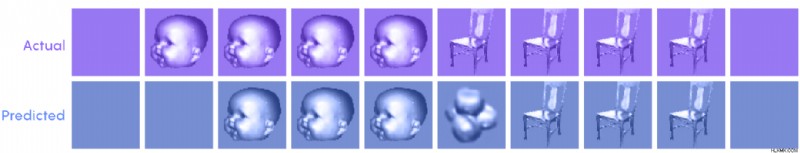

次に、チームは、1234567890、3456789012、6789012345 などのように、昇順のラップアラウンド順序で連続する数字の多数のシーケンスで RNN をトレーニングしました。各数字は、28 x 28 ピクセルの画像の形式でネットワークに表示されました。 RNN は、シーケンス内の任意の場所から開始して、次の数字が何になるかを予測できる内部モデルを学習しました。しかし、ネットワークはユニット間の可能な限り最小の重みでこれを行うことを余儀なくされました。これは、生物学的神経系における低レベルの神経活動に似ています。

これらの条件下で、RNN はシーケンス内の次の数字を予測することを学習しました。その人工ニューロンの一部は、予想される入力のモデルを表す「予測ユニット」として機能しました。他のニューロンは、予測ユニットが次の数字を正しく予測することをまだ学習していないときに最も活発な「エラーユニット」として機能しました。これらのエラーユニットは、予測ユニットが正しくなり始めたときに抑制されました。重要なことは、ネットワークがこのアーキテクチャにたどり着いたのは、エネルギー使用量を最小限に抑える必要があったためです。キーツマン氏は、「人々が通常システムに明示的に組み込んでいるような抑制を行うことを学習するだけです」と述べています。 「私たちのシステムは、エネルギー効率を高めるために緊急に行うべきこととして、すぐに使用できます。」

要点は、エネルギーの使用を最小限に抑えるニューラル ネットワークは、ある種の予測処理を実装することになるということです。これは、生物の脳がおそらく同じことを行っていることを示しています。

Rajan は、キーツマンの研究を「エネルギー最小化のようなトップダウンの制約が、予測コーディングのような特定の機能に間接的につながる方法の非常に優れた例」と呼んでいます。 RNN 内の特定のエラーおよび予測ユニットの出現は、ネットワークのエッジにあるニューロンだけが入力を受け取っているという事実の意図しない結果ではないかと彼女は考えるようになりました。入力がネットワーク全体に分散されている場合、「私の推測では、エラー ユニットと予測ユニットの分離は見られませんが、それでも予測アクティビティは見られるでしょう」と彼女は言いました。

脳の行動を統一するフレームワーク

計算研究からのこれらの洞察は説得力があるように見えるかもしれませんが、最終的には、生きた脳からの証拠のみが脳内の予測処理について神経科学者を納得させることができます.この目的のために、マギル大学とケベック人工知能研究所のミラの神経科学者でコンピューター科学者であるブレイク・リチャーズと彼の同僚は、予期しない出来事について予測することを学ぶ脳で何を見るべきかについて、いくつかの明確な仮説を立てました.

彼らの仮説を検証するために、彼らはシアトルのアレン脳科学研究所の研究者に頼り、脳の神経活動を監視しながらマウスで実験を行いました。特に興味深いのは、解剖学的に予測処理に適していると考えられている脳の新皮質の特定の錐体ニューロンでした。それらは、近くのニューロンから (細胞体への入力を介して) 局所的なボトムアップの感覚信号と、より遠くのニューロンから (先端樹状突起を介して) トップダウンの予測信号の両方を受け取ることができます。

マウスには、明るい部分と暗い部分のストライプで構成されるガボール パッチの多くのシーケンスが示されました。各シーケンスの 4 つのパッチはすべてほぼ同じ向きであり、マウスはそれを期待するようになりました。 (「これらのシーケンスを見るだけで、地獄のように退屈だったに違いありません」とリチャーズは言いました。) 次に、研究者は予期しないイベントを挿入しました。4 つ目のガボール パッチがランダムに別の方向に回転しました。動物たちは最初は驚きましたが、やがて驚きの要素も期待するようになりました。その間ずっと、研究者はマウスの脳内の活動を観察しました。

彼らが見たのは、予想される刺激と予想外の刺激に対して、多くのニューロンが異なる反応を示すことでした。重要なことに、この違いは、テストの初日にローカルのボトムアップ シグナルで強かったのですが、2 日目と 3 日目には弱まりました。予測処理の文脈では、これは、刺激がそれほど驚くべきものではなくなるにつれて、新しく形成されたトップダウンの期待が、入ってくる感覚情報への反応を抑制し始めたことを示唆しています.

一方、先端樹状突起では逆のことが起こっていました。予期しない刺激に対する反応の違いは、時間の経過とともに増加しました。神経回路は、次回より良い予測を行うために、驚くべき出来事の特性をより適切に表現することを学習しているように見えました.

「この研究は、予測学習や予測コーディングのようなものが新皮質で起こっているという考えをさらに裏付けるものです」と Richards 氏は述べています。

確かに、ニューロン活動や動物の行動の個々の観察結果は、脳の他のモデルによって説明できる場合があります。たとえば、同じ入力に対するニューロンの反応の弱まりは、エラー ユニットの抑制として解釈されるのではなく、単純に適応プロセスによるものかもしれません。しかし、その後、「さまざまな現象の説明が記載されたこの電話帳全体が得られます」と de Lange 氏は述べています。

一方、予測処理は、多くの現象を一度に説明するための統一的なフレームワークを提供するため、脳の仕組みの理論としての魅力があります。 「この時点での証拠はかなり説得力があると思います」とリチャーズは言いました。 「実際、私はその主張に多額の資金を投じても構わないと思っています。」